「コンテンツを練っても検索上位に上がらない」

「評価をうまくひとつのページに集められない」

「エンジニアにどう依頼すればいいかわからない」

ページ数が数万を超える大規模サイトでこんな悩みを抱えていませんか?

実は、大規模サイトのSEOが成功するかどうかは、コンテンツの質以前の「サイト設計」で決まります。検索エンジンに膨大なページを正しく発見・評価してもらうための土台作りが、最も欠かせません。

本記事では、データベース型サイト特有の課題を解決するための、実践的なSEO戦略を徹底解説します。

- 大規模サイトの思いな課題

- 大規模サイトにおけるSEO改善施策

- 自然検索流入が140%増加した成功事例

- SEOリスク管理術

福田卓馬

福田卓馬大規模サイトのSEOは、技術的な設計が成否を分けます。この記事で、確実に成果を出すための技術戦略を身につけましょう。

この記事を読めば、これまで曖昧だった大規模サイトのSEO戦略が明確になり、自信を持って開発チームに改善指示を出せるようになります。

Googleのアルゴリズム変動に左右されない強固なサイト基盤を構築するために、ぜひ最後までご覧ください。

さらに具体的な施策事例を知りたい方は、記事の最後でご紹介する「【EC成功事例集】ECサイトのSEO施策40選ハンドブック」もご活用いただけます。

\60P超えのコンテンツを無料配布!/

ECサイトのSEO対策&売上アップ施策をまとめたコンテンツを無料配布!検索順位を上げてセッションを増やす方法から、購買率を高めるノウハウまで成功事例含めて網羅しています。ぜひ無料で受け取って活用してください。

大規模サイトSEOの基本

大規模サイトとは、商品や物件といったデータをデータベースから呼び出し、動的にWebページを生成するサイトを指します。

数万〜数百万ものページ数になるため、1ページずつ手作業で修正するブログサイトのようなSEO手法は通用しません。

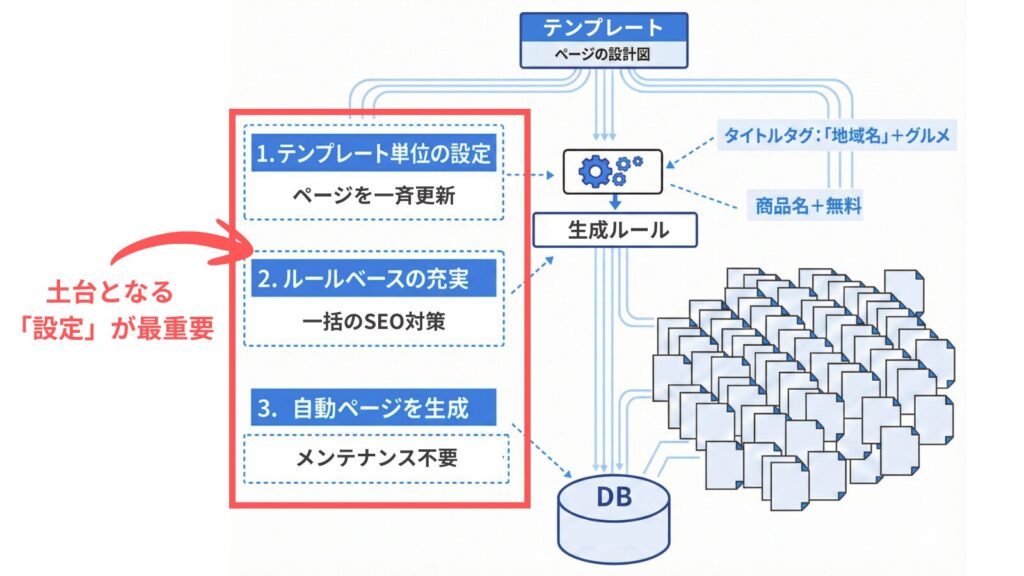

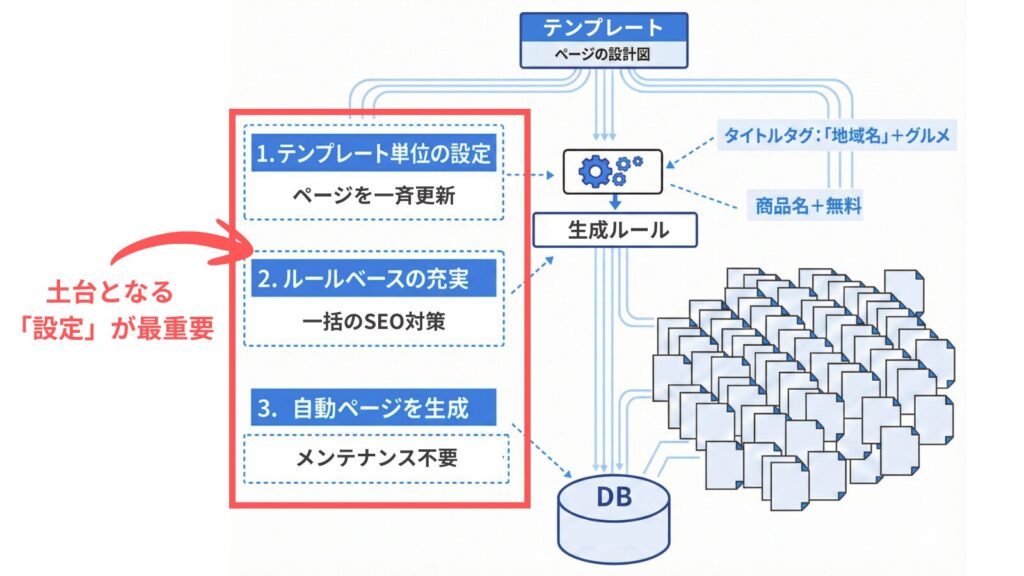

大規模サイトのSEOでは、ページの設計図である「テンプレート単位での改修」および、サイト全体の動きを制御する「ルールベースでの実装」がメインです。

良質なコンテンツを作る以前に、膨大なページを検索エンジンに正しく発見させ、評価してもらうための土台作りが最優先課題となるでしょう。

経験則上、大規模サイトの運営に悩んでいる企業様のほとんどは、土台づくりができていないため、まずは技術的な課題を見直していきましょう。

大規模サイトSEOで発生しやすい問題点

多くの大規模サイトが検索で伸び悩んでしまうのは、SEOの技術的な課題が挙げられます。

- クロールが浪費されてしまう

- 自動生成により重複ページが大量にできる

- サイト構造が複雑で評価されづらくなる

上記の問題を把握し、改善しなければ、大規模サイトが正しく評価されることはありません。

少し専門的な内容になってしまいますが、できるだけ噛み砕いて解説していきますので、必ず目を通していってください。

クロールが浪費されてしまう

大規模サイトでは、Googleのクローラーが巡回できるページ数の上限、いわゆる「クロールバジェット」の浪費が大きな問題となります。

あるWebサイトを一定期間内にクロールできる時間とリソースの上限のこと。

多くの大規模サイトでは、サイト内に低品質なページ、および似たような重複ページが大量に存在します。この状態では、クローラーが無駄なページへの巡回でリソースを使い果たしてしまい、重要なページをしっかり見てもらえません。

たとえば、新商品のページがなかなか検索結果に表示されない、といった機会損失は、この問題が原因であるケースが多く見られます。

クロールバジェットの浪費は、新しいページの発見を遅らせ、ビジネス機会の損失につながります。

大規模サイトSEOでは、重要なページへ優先的にクローラーを誘導するという制御が欠かせません。

自動生成により重複ページが大量にできる

大規模サイトでは、検索条件の組み合わせによって、中身がほぼ同じページが意図せず大量に生成されてしまいます。

たとえば「商品の色違い」「サイズ違い」「検索結果の並び替え順」で異なるURLが作られると、Googleはそれぞれを別のページとして認識します。

その結果、本来1つのページに集まるべき評価が複数のURLに分散し、どのページも上位表示できなくなる「カニバリ」を引き起こします。

サイト内で似た内容のページが競合し、検索評価が分散してしまう現象のこと。

サイトの評価を最大化するには、重複ページを1つの代表URLに統合する「正規化」と呼ばれる処理が必須です。

重複ページの放置は、サイトの評価を大きく損なう原因です。正規化で評価を1つに集約しましょう。

サイト構造が複雑で評価されづらくなる

サイトの階層が深くなりすぎると、トップページが持つ評価(リンクジュース)がサイトの末端にある重要なページまで行き渡らなくなります。

検索エンジンはサイト内のリンクをたどって各ページの重要度を判断します。トップページから何度もクリックしないとたどり着けないページは、重要度が低いと見なされ、クローラーの巡回頻度も低下しまうのです。

つまり、サイト構造が深くなればなるほど、リンクジュースが希釈されてしまいます。

サイトの隅々まで評価を届けるには、すべてのページがトップから数クリック以内で到達できる、計画的な内部リンク設計が求められます。

サイト構造が深すぎると、重要なページにも評価が届きません。論理的な内部リンク設計で評価を循環させましょう。

これらの問題はサイト規模が大きくなるほど深刻化します。ECサイトなどで実際に起きたトラブル事例と対策をまとめたハンドブックで、自社の現状と照らし合わせてください。

\60P超えのコンテンツを無料配布!/

ECサイトのSEO対策&売上アップ施策をまとめたコンテンツを無料配布!検索順位を上げてセッションを増やす方法から、購買率を高めるノウハウまで成功事例含めて網羅しています。ぜひ無料で受け取って活用してください。

大規模サイトを成功させるSEOのポイント

大規模サイト特有の問題点を解決するためには、技術的なアプローチが欠かせません。

ここでは、サイトの評価を最大化し、検索エンジンに正しくコンテンツを伝えるための具体的な5つのポイントを解説します。

- XMLサイトマップの分割でクロール効率を最大化

- URLを正規化して評価を正しく集める

- パラメータ制御で無駄なクロールを避ける

- noindex/robots.txtで低品質ページのインデックスを避ける

- 評価の集まりやすい内部リンク構造を可視化する

XMLサイトマップの分割でクロール効率を最大化

XMLサイトマップは、ただ生成するだけでなく、戦略的に分割して送信することがクロール効率の最大化につながります。

Webサイト内のページURL、最終更新日、更新頻度などをまとめた、検索エンジン向けの地図ファイルのこと。

サイトマップには1ファイルあたり5万URL、または50MBまでという上限があるため、大規模サイトでは「カテゴリ別」や「更新月別」などでファイルを分割します。

分割することで、Google Search Console上で「どのカテゴリのインデックス登録率が低いか」といった問題の特定が容易になり、改善のアクションを取りやすくなります。

サイトの状況を正確に把握するためにも、サイトマップの分割運用は必須の施策です。

サイトマップを分割すると、問題のあるカテゴリを特定しやすくなり、改善が加速します。

URLを正規化して評価を正しく集める

検索パラメータなどによって生成される重複URLの評価を統合するために、canonicalタグの正しい設定が重要です。

検索エンジンに対して「このページの正式なURLはこちらです」と伝える役割を持つタグのこと。

canonicalタグを使えば、評価を正規URLに指定できるため、前述した「似たような複数のページに評価が分散してしまう」という問題を解決できます。

実装するときは、すべてのページに自らを指す「自己参照canonical」をドメイン名から記述する「絶対パス」で設定するのが鉄則です。

canonicalの話は少し専門的な部分になってくるため、正しい使い方についてある程度理解が必要です。

canonicalへの理解を深めたい方、または実際に実装したい方は「canonicalタグとは?正しい書き方まで徹底解説」にて詳しく解説していますので、参考にしてください。

パラメータ制御で無駄なクロールを避ける

SEOでの流入を目的としない不要なページへは、robots.txtファイルを使ってクローラーがアクセスしないように制御することが欠かせません。

収集されたくないコンテンツをクロールされないように制御するファイルのこと。

robots.txtでクロールを拒否(Disallow)することで、限られたクロールバジェットを重要なページに集中させられます。

たとえば、複数の条件を掛け合わせた「絞り込み検索結果ページ」は、ユーザーニーズが限定的で重複コンテンツにもなりやすいため、クロールを拒否する代表的なケースです。

サイトのリソースを有効活用するため、クロールさせる必要のないURLパターンを明確にし、robots.txtで適切に制御しましょう。

robots.txtで不要なページへのクロールを防ぎ、重要なページにリソースを集中させましょう。

noindex/robots.txtで低品質ページのインデックスを避ける

ユーザーにとって価値が低いページは、noindexタグを設定して検索エンジンのインデックスから除外するべきです。

検索エンジンにサイトやページをインデックスさせないようにするためのタグのこと。

低品質なページが大量にインデックスされると、サイト全体の評価が下がる原因となります。

具体的には「検索結果が0件のページ」や、「エリア×職種×特徴」のように過度に検索条件を掛け合わせた需要の少ないページなどが対象です。

価値の低いページをインデックスさせない判断は、サイトを「負の遺産」から守り、SEO評価を高めるための重要な戦略です。

低品質ページの大量インデックスは、サイト全体の評価を下げます。noindexで適切に除外しましょう。

noindexタグの正しい使い方については「No Indexに関する3つの誤解と正しい理解」の記事で詳しく解説しています。

評価の集まりやすい内部リンク構造を可視化する

サイト内のページ同士を関連性の高いリンクで結びつけることで、ユーザーと検索エンジンの双方にとって分かりやすい構造を作ります。

パンくずリストや関連商品レコメンドなどの内部リンクは、ページ間の評価の受け渡しをスムーズにし、サイト全体のテーマ性を強化する役割を担います。

Webサイトで、今見ているページがサイト全体のどこにあるかを階層的に示したナビゲーションのこと。「TOP > カテゴリー > 現在のページ」のように表示され、ユーザーが迷子になるのを防ぎ、上位の階層へ戻りやすくする。

たとえば、関連商品の表示をランダムにするのではなく、「同じカテゴリ」や「同じ特徴タグを持つ商品」といったロジックで制御すると、専門性が高いサイトとして評価されやすくなります。

論理的な内部リンク設計は、サイト内の評価を循環させ、SEO効果を最大化するための基盤となります。

大規模サイトでポータル型の構造を検討している方は「ポータルサイトSEO対策|一覧ページと詳細ページの役割分担」の記事をご覧ください。

大規模サイトSEOの成功事例【数値で見る改善効果】

技術的なSEO施策が、実際にどのような成果につながるのか、改善事例を2つ紹介します。

ページ数が多いECサイトの事例

弊社のクライアントのECサイトの事例です。

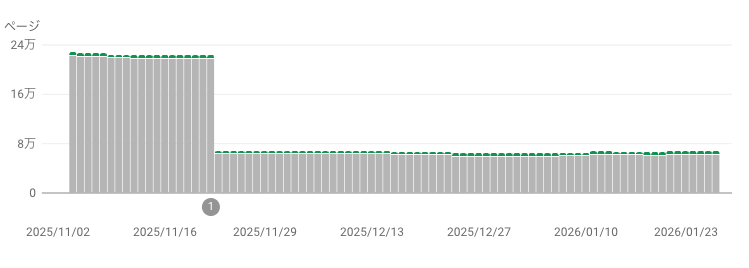

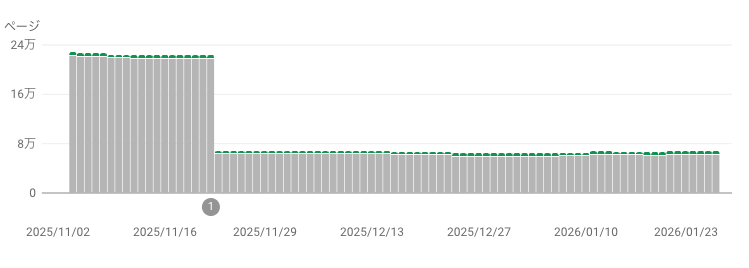

もともとは、絞り込み検索などの動的生成ページに対して正しくクロール制御ができておらず、不要な29万ページに対してクロールバジェットが割かれている状態でした。

そこで、弊社ではrobots.txtによるクロール制御を試みたところ、およそ3ヶ月ほどかけて29万以上あった不要ページのクロールは6万ページほどに抑えられます。

さらに注目してほしいのが、不要ページのクロールを抑えたことで、狙いたいキーワードの検索順位が全体的に上昇してきたという事実です。

技術的な改善だけで、インデックス率の改善や検索順位の大幅上昇が実現できます。

また、該当メディアではオウンドメディアも活用した戦略で成果を上げています。ECサイトを運営されている方は「ECサイトにオウンドメディアは必須」の記事も併せてご覧ください。

一般的なブログサイトの事例

こちらは大規模サイトではないのですが、同じく技術的なSEO改善によってトラブルを回避できたので、合わせて紹介しています。

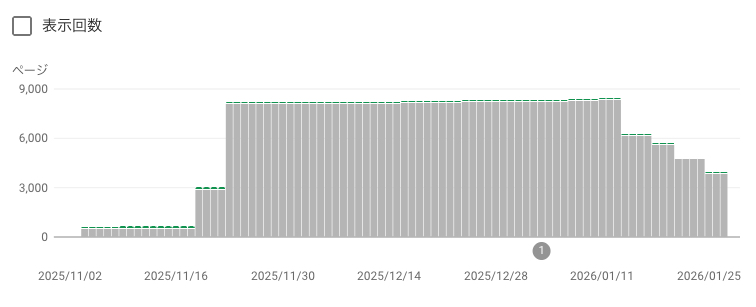

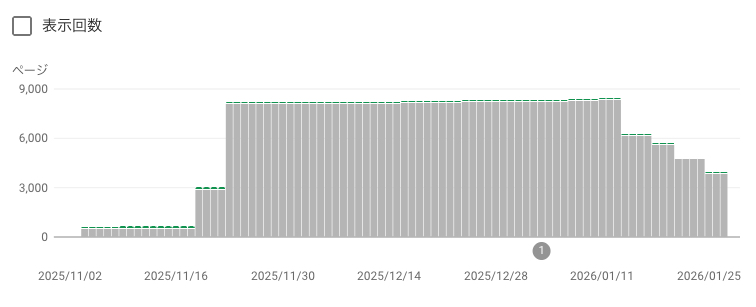

当該サイトは、海外からのスパム攻撃により、トップページのURLにパラメーターが付与された不要URLが大量にクロールされている状態でした。

対応策として、GoogleサーチコンソールのデータをダウンロードしてAIに読み込ませ、どのようなパラメーターが付与されているのかを特定しました。

さらに、AIで抽出されたパラメーターに対してrobots.txtでのクロール制御、.htaccessの調整を施したことで、不要ページが8,000件から3,000件以上に減少しています。

Webサーバー(主にApache)の挙動を、フォルダ単位で制御するための設定ファイルのこと。

大規模サイトでもないのに、不自然にインデックス未登録が増えているのであれば、スパムも疑いましょう。

大規模サイトSEOでエンジニアと連携するコツ

技術的なSEO施策は、エンジニアとの円滑な連携が成功のカギを握ります。

しかし、マーケターの意図を開発チームに正確に伝え、実装してもらうことに難しさを感じる担当者も少なくありません。

ここでは、開発チームへの依頼をスムーズに進めるための具体的なコツを紹介します。

- SEO施策を「仕様書」に落とし込む

- 費用対効果を算出する

- リスクを避けるためテスト環境で検証する

SEO施策を「仕様書」に落とし込む

SEO施策の依頼は、口頭ではなく必ず「仕様書」としてドキュメントにまとめることが欠かせません。

ドキュメント化することで、実装の要件が明確になり、担当者間の認識のズレや実装漏れといったトラブルを防げます。

たとえば、「もしこの条件のページならば、このパターンのtitleタグを出力する」というように、エンジニアが理解しやすい条件分岐の形式で記載すると、意図が正確に伝わります。

URLの生成ルールやcanonicalタグの出力条件などを具体的に明記した仕様書を作成し、円滑な開発連携を実現しましょう。

口頭での依頼ではなく、条件分岐まで明記した仕様書が、正確な実装への近道です。

費用対効果を算出する

SEO施策の実行には開発リソースが求められるため、事前に費用対効果を算出して社内を説得することが欠かせません。

施策によってどれくらいのビジネスインパクトが見込めるかを具体的に示すことで、開発の優先順位を上げ、必要な工数を確保しやすくなります。

たとえば「インデックスされるページ数がこれだけ増え、想定されるクリック率を掛けると、これだけの売上増加が見込めます」といった論理で説明します。

また、不要なクロールを減らしてサーバー負荷も軽減できるといったエンジニア側の利点も伝え、協力的な関係を築きましょう。

費用対効果を具体的に示せば、開発チームの協力を得やすくなります。

リスクを避けるためテスト環境で検証する

SEOに関するシステム改修は、必ず本番環境にリリースする前にテスト環境で検証することが欠かせません。

事前検証を怠ると、意図しない設定ミスによってサイト全体の検索順位が急落するなど、致命的な問題を引き起こすリスクがあります。

たとえば、テスト用のnoindexタグが残ったまま公開されたり、canonicalタグのドメインがテスト環境のままになっていたりする失敗は後を絶ちません。

こうした事故を防ぐため、事前にチェックリストを作成し、ひとつずつ確認するプロセスを徹底しましょう。

テスト環境での検証と、リリース前のチェックリスト確認で、致命的なミスを防げます。

本体サイトだけでなく、サブディレクトリのオウンドメディアも同時にリニューアルする場合は、記事コンテンツのURL移行にも細心の注意が必要です。詳しくは「オウンドメディアのSEO改善施策20選」で紹介しております。

大規模SEOのサイトリニューアル・システム移行時のリスク管理

大規模サイトのリニューアルは、SEOの評価を大きく損なうリスクを伴います。

URL構造やサイト設計が大きく変わるため、適切な移行措置を講じなければ、これまで蓄積してきた検索順位や流入を失いかねません。

安全に移行を完了させるための重要なリスク管理策について解説します。

- 移行前に押さえるべきSEOチェックリスト

- 301リダイレクトの設計と検証手順

- 移行後のモニタリングと緊急時対応

移行前に押さえるべきSEOチェックリスト

サイトリニューアルの最初のステップは、現状のSEO資産を正確に把握することです。

現行サイトで検索流入を獲得しているページをすべてリストアップし、それぞれのページが持つ評価をリニューアル後も引き継ぐ計画を立てましょう。

リストアップしたURLを元に、新しいサイトでも同じURLを維持するのか、あるいは新しいURLに変更してリダイレクト処理をするのかを1ページずつ丁寧に分類していきます。

この地道な作業が、リニューアルによる流入減少のリスクを最小限に抑えるための最も重要な土台となります。

現状のSEO資産を正確に把握し、1ページずつ移行計画を立てることが、リニューアル成功の土台です。

301リダイレクトの設計と検証手順

URLが変更されるページについては、旧URLから新URLへ評価を正しく引き継ぐための301リダイレクト設定が欠かせません。

URLが恒久的に変更される際に利用する転送処理のこと。

301リダイレクトは、検索エンジンに対してURLが恒久的に移転したことを伝え、旧ページが持っていた評価を新ページに引き継がせるための重要な指示です。

リダイレクト設定では、まず旧URLと新URLの対応表を作成します。

正規表現を使えば一括で設定できますが、意図しないページに転送される誤作動のリスクもあるため、設定後は必ずテストが必要です。

綿密な設計と検証を通じて、リダイレクト漏れや設定ミスを防ぎましょう。

301リダイレクトは、旧URLと新URLの対応表を作成し、必ずテスト検証しましょう。

移行後のモニタリングと緊急時対応

サイトリニューアルは、リリースして終わりではありません。

移行後のモニタリング体制を整えておくことが極めて重要です。

リリース直後は予期せぬ不具合が発生する可能性が最も高いため、早期に問題を発見し対処することで、被害を最小限に食い止められます。

アクセスログやGoogle Search Consoleを毎日確認し、404エラーの急増やインデックス数の異常な減少などがないかを監視します。

万が一に備え、速やかに元の状態に戻す「ロールバック」の判断基準をあらかじめ決めておくと、迅速な意思決定が可能です。

リリース後の毎日のモニタリングと、ロールバック基準の事前設定が、リスクを最小化します。

大規模サイトのSEOで外注を検討するタイミング

大規模サイトのSEOは高度な専門知識を要するため、自社だけで対応するのが難しい場面もあります。

ここでは、専門家への外注を検討すべき具体的なタイミングについて解説します。

適切なタイミングで外部の知見を取り入れることが、成果への近道となる場合があります。

- 社内リソースだけでの対応が困難

- 社内に技術者がおらず実装が難しい

- サイト設計への投資判断ができない

これらの状況に当てはまる場合は、外部の専門家の協力を得ることを検討しましょう。

社内リソースだけでの対応が困難

サイトのページ数が数万、数十万を超えると、手作業での分析や改修は物理的に不可能になります。

たとえば、全ページのタイトルタグをチェックしたり、特定のページ群にだけタグを設置したりといった作業は、膨大な工数がかかり現実的ではありません。

専門家が持つ分析ツールや、プログラムによる一括処理のノウハウを活用することで、社内で進めるよりもはるかに速く、正確に施策を実行できます。

人力での対応範囲を超えたと感じた時が、外部リソースの活用を検討する一つのタイミングです。

数万ページを超えたら、専門家のツールとノウハウを活用することで、大幅な時間短縮が可能です。

社内に技術者がおらず実装が難しい

SEOの改善策を立案できても、それをシステムに実装する技術的な知見が社内に不足している場合があります。

特に、マーケティング担当者と開発担当者の間に立ち、SEO要件を技術的な仕様に翻訳できる人材がいないケースでは、施策が計画倒れになりがちです。

専門のコンサルタントは、マーケターの意図を汲み取り、エンジニアが実装可能なレベルの要件定義書を作成する役割を担います。

施策の「実行」段階で壁にぶつかっている場合は、マーケティングと技術の両面を理解する外部パートナーの協力が解決策となります。

マーケターとエンジニアの橋渡しができる専門家がいると、施策の実行がスムーズに進みます。

サイト設計への投資判断ができない

部分的な改修では解決できない、サイトの根本的な構造に問題がある場合、専門家の客観的な視点が求められます。

サイトリニューアルのような大規模な投資には、その妥当性を裏付ける客観的なデータと専門的な分析が欠かせません。

専門家は、競合分析や市場データに基づき、データベース構造やカテゴリ設計の見直しによる具体的な改善効果をシミュレーションし、投資判断の材料を提供します。

大きな経営判断を伴う根本的なサイト改善では、第三者の専門的な知見を求めることが成功の確率を高めます。

大規模投資の判断には、客観的なデータと専門家の分析が欠かせません。

オウンドメディア側のSEO対策であれば、大規模システムを触らずとも、コンテンツの質で勝負が可能です。詳しくは「オウンドメディアのメリットデメリットやホームページとの違い」で解説しています。

よくある質問

大規模サイトの定義はページ数どれくらいからですか?

明確な定義はありませんが、一般的には数万ページ以上が目安とされます。

しかし、ページ数そのものよりも、「データベースの情報をもとにプログラムが自動でページを生成している」というサイトの仕組みが本質的な特徴です。

この仕組みにより、手作業でのページ管理が不可能になり、技術的なSEO対策が欠かせなくなります。

ページ数だけでなくサイトの生成方法によって、大規模サイトかどうかが決まるといえます。

クロールバジェットが不足しているか確認する方法は?

クロールバジェットの不足は、Google Search Consoleを使って簡易的に確認できます。

まず「設定」から「クロールの統計情報」を開き、クロールアクティビティが低下していないかを確認します。

次に、「インデックス作成」内の「ページ」レポートで「検出 – インデックス未登録」のURLが増加していないかをチェックします。

このステータスは、ページの存在は認識されているものの、リソース不足でクロールが後回しにされている状態を示すため、バジェット不足の有力なサインです。

不要なパラメータ付きURLはnoindexとcanonicalどちらが良い?

不要なパラメータ付きURLの制御は、目的によって使い分けるのが正解です。

そもそもクロールさせる価値もないページは、robots.txtでクロール自体を拒否するのが妥当です。

一方、内容は重複しているものの、検索エンジンからの評価をまとめたいというページにはcanonicalタグを使用します。

クロールリソースを節約したい場合はrobots.txt、ページの評価を統合したい場合はcanonicalと、目的に応じて最適な手段を選択しましょう。

データベース型サイトのSEOコンサル費用の相場は?

データベース型サイトのSEOコンサルティング費用は、一般的なコンテンツSEOと比較して高額になる傾向があります。

単にキーワード分析やコンテンツ作成だけでなく、サイトのシステム仕様を理解し、プロジェクトマネジメントまで担う必要があるためです。

関わる領域が広く、高度な専門性が求められることから、費用の相場は月額50万〜100万円以上かかります。

EXTAGEの無料相談では、サイトの状況を診断して事前にお見積もりを出します。他社様と見積もり比較していただいても問題ございませんので、ご気軽に相談してください。

システム改修が難しい場合、コンテンツ追加だけで対策できますか?

システム本体の改修が難しい場合でも、コンテンツ追加によってSEOを改善する戦略は存在します。

サイトの技術的な問題を根本から解決できませんが、ユーザーが検索するようなお役立ち情報を発信するブログを立ち上げることで、新たな集客経路を作れます。

たとえば、ECサイトであれば商品の使い方や選び方に関する記事を作成し、そこから商品ページへユーザーを誘導します。

システム改修が長期的な課題となる場合、まずはコンテンツ施策で集客の「迂回ルート」を作り、ビジネス機会を創出することが有効な一手となります。

大規模サイトのSEO改修は、失敗すると数ヶ月分の売上を失うリスクがあります。他社の成功・失敗事例を事前にインプットし、確実な設計図を描くために、このハンドブックを活用してください。